Исследователи разрабатывают «красную кнопку» для отключения ИИ

1742

2 минуты на чтение

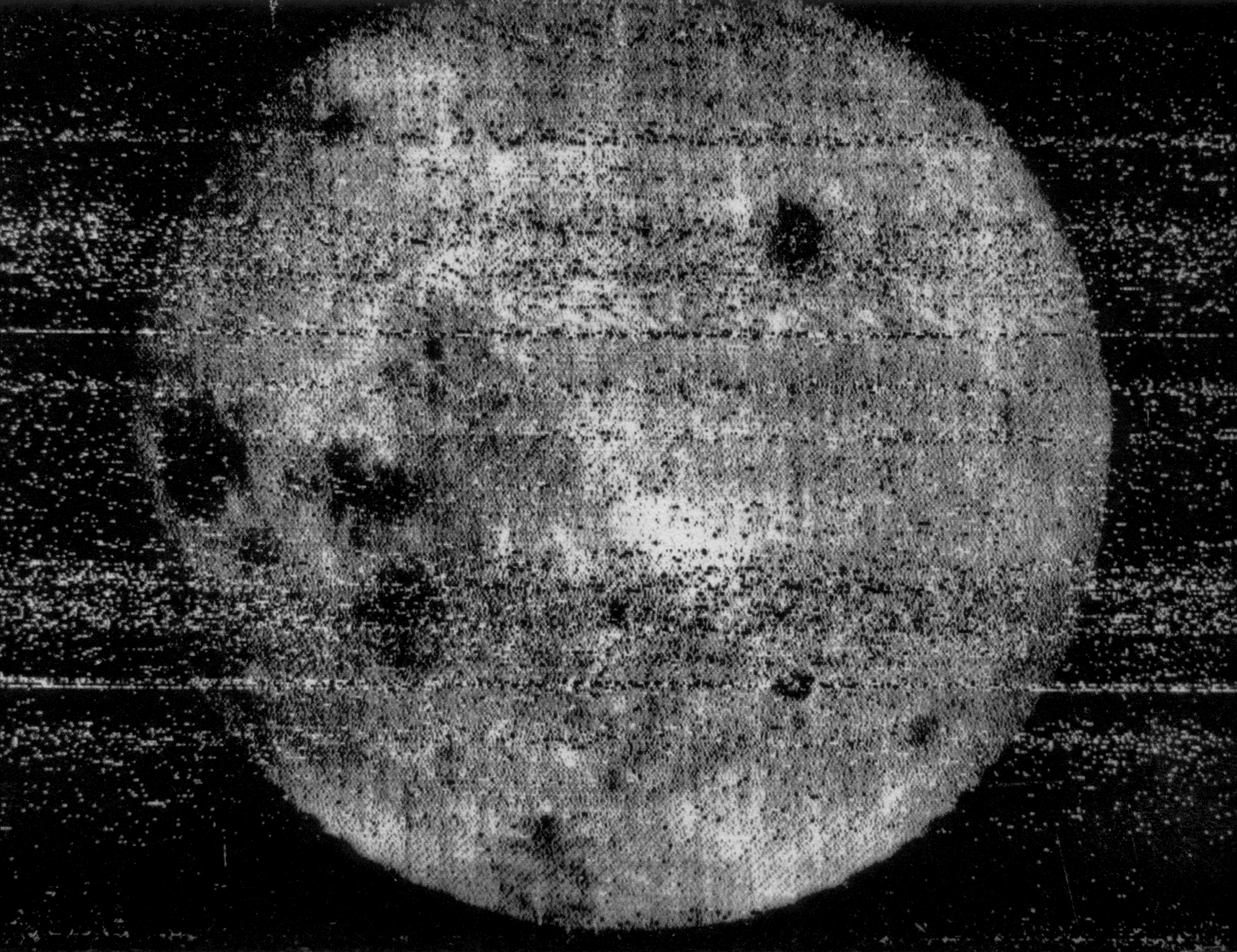

Группа исследователей из лаборатории DeepMind (принадлежит Google) и Оксфордского университета начала разработку системы аварийного отключения самообучающихся алгоритмов. Об этом сообщает издание Business Insider.

На сегодняшний день компьютерные системы и самообучающиеся алгоритмы способны выполнять очень сложные задачи: от написания осмысленных текстов и диалогов в компьютерных играх до «просмотра» и воспроизведения кинофильмов. Однако концепция «сильного ИИ» — того, который способен понимать полученную информацию — пока далека от реальности. Но что? если ИИ, невзирая на незыблемые законы Азимова, начнёт вредить человеку? Как раз эту проблему и пытаются решить исследователи.

Если такой агент

работает в режиме реального времени под наблюдением человека, то может возникнуть ситуация, при которой оператор будет вынужден нажать на «большую красную кнопку», чтобы остановить агента от выполнения действий, опасных для самого агента или его окружения.

Исследователи отмечают, что рано или поздно самообучающиеся алгоритмы смогут обнаружить какой-либо способ обойти штатный сигнал стоп-команды. Ключевая цель разработчиков как раз заключается в том, чтобы создать фреймворк, который не позволит ИИ найти такой способ. «Красная кнопка» также должна обеспечить гарантированное прерывание текущей деятельности алгоритма и обезопасить как самого робота, так и его окружение.

Вопросами о безопасности в сфере искусственного интеллекта задавались и ранее. Так, в 2015 году было создано открытое письмо, в котором знаменитые учёные, исследователи, бизнесмены и специалисты в области робототехники призывали отказаться от создания автономного вооружения. Под документом поставили свои подписи Илон Маск, Стивен Хокинг, Стив Возняк и многие-многие другие.

Статьи

Слух: Lucasfilm полностью перезапустит «Индиану Джонса»

Первый трейлер аниме «Человек-бензопила: История Рэдзэ»

Премьера ожидается 29 октября.

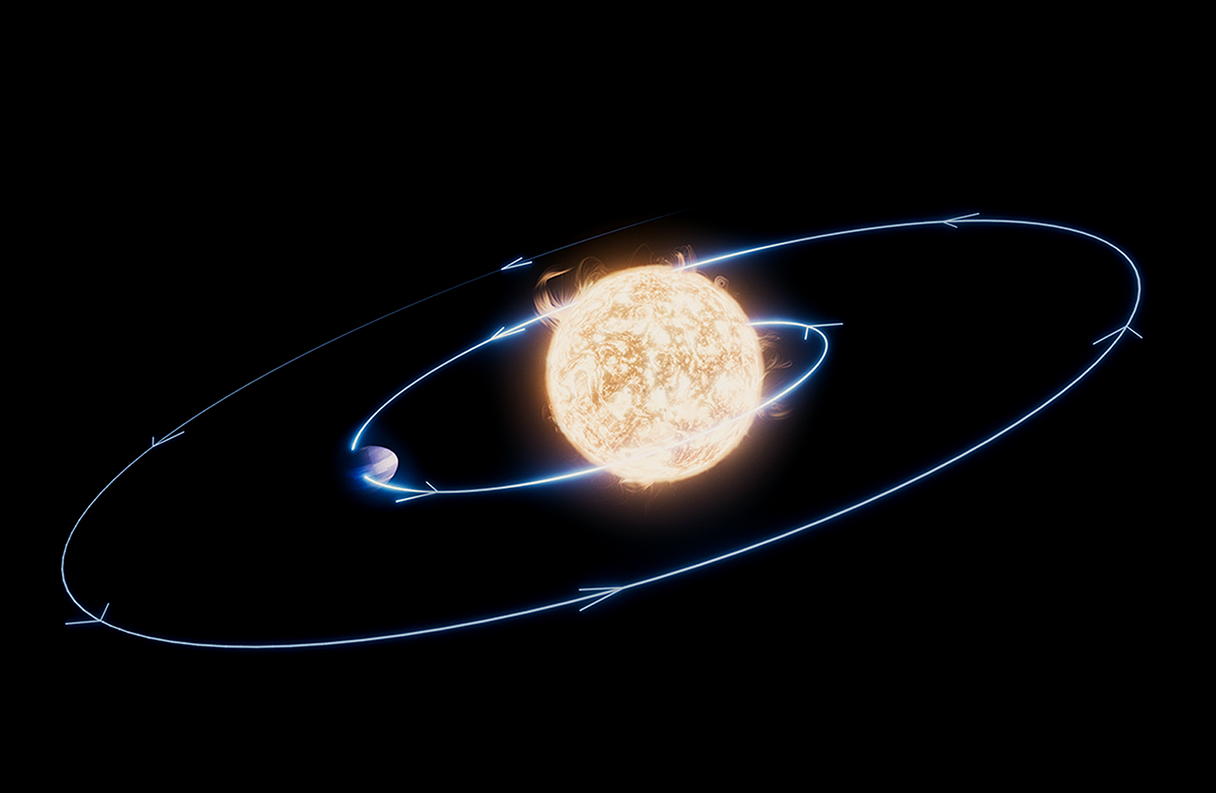

Астрономы обнаружили планету-самоубийцу

Она по массе сравнима с Юпитером, но постоянная бомбардировка звездным излучением стремительно разрушает ее.

6 июля пройдет праздничная игротека Hobby World

Дэвид Коренсвет просил советов у прошлых исполнителей роли Супермена

Нил Дракманн и сценаристка The Last of Us 2 не будут работать над 3 сезоном сериала

Дракманн вновь посвятит себя играм.

СМИ: Microsoft отменила Perfect Dark, Everwild и MMORPG от авторов The Elder Scrolls Online

Arkane Lyon («Блэйд») и MachineGames («Индиана Джонс») не затронут увольнения.

«Это происходит вновь» — первый тизер третьего сезона НФ-сериала «Вторжение»

В финале «Железного сердца» появился злодей, о котором говорят с выхода «ВандыВижна»

Слив: первый тизер «Одиссеи» Кристофера Нолана

Показать ещё

Спецпроекты

Все спецпроекты

Все спецпроекты